Analyse von Prozessdaten – ein guter Einstieg in die Digitalisierung

„Mein Chef sagt, ich soll Digitalisierung machen…“: Ein Zitat von Professor Nejdl beim Kongress „Industrie4.0“ der Niedersachsenmetall, mit dem er das Dilemma vor allem der mittelständischen Industrie zum Einstieg in Industrie4.0 motivierte.

Aber das ist doch schon ein guter Anfang. Das Potential wurde erkannt, nur besteht große Unsicherheit, wie man das Thema zielführend anpacken kann. Die meisten Firmen haben in der Vergangenheit schon viele Daten gesammelt, nutzen diese aber oftmals nicht - aus verständlichen Gründen. Datenbanken ohne Datenanalyse und Zielstellung sind eben einfach nur große Mengen von Zahlen. Dabei zeigen die Daten aus der Produktion oftmals schon wertvolle Zusammenhänge auf. Im Kontext jedoch mit einer Datenanalyse können aus diesen Zahlen Informationen werden, die für eine Optimierung eingesetzt werden können.

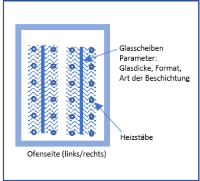

In vielen Industrien werden Produkte in Öfen erwärmt. Die Kenntnis, wie sich der Prozess im Ofen verhält, ist entscheidend für die Qualität des Produktes. Als Beispiel für eine Datenanalyse zeige ich Daten aus einem Prozess zur Glasverarbeitung, in dem drei (nominell) gleiche Öfen eingesetzt werden, ähnlich wie sie in Abbildung 1 dargestellt sind. In Diesen werden Glasscheiben erwärmt. Parameter für den Prozess sind die Glasdicke, die Verweilzeit im Ofen, die Scheibengröße und der Einfluss verschiedener Beschichtungen, so dass sich insgesamt acht Parameter ergeben, die in den Daten erfasst wurden. Die Zielstellung ist es, das Glas auf einen Temperaturbereich von 90°C (Untere Spezifikationsgrenze = USG) bis 130°C (Obere Grenze = OSG) zu erwärmen.

Die statistische Datenanalyse verbindet nun das Qualitätskriterium (Temperatur der Glasscheiben) mit den Prozess¬parametern. Das Ergebnis ist ein mathematisches Modell, das die Erwärmung des Glases als Funktion der acht Prozessparameter vorhersagt. Da acht Dimensionen des Modells schwer darstellbar sind, ist in Abbildung 2 jeder gemessene Temperaturwert (Beobachtet) als Funktion der Temperatur aus dem Modell (Vorhersagt) aufgetragen. Die Werte aus dem Modell wurden aus den acht Parametern berechnet. Ein perfektes Modell würde alle gemessenen Werte genau erklären können, so dass alle beobachteten Werte auf einer 45° Diagonale im Diagramm zu sehen sind. Das Ergebnis des Modells zeigt, dass die Diagonale im Trend gut zu erkennen ist, aber noch ein Rest „Rauschen“ verbleibt. Die statistische Analyse ergibt, dass 90% der Variationen durch dieses Modell erklärt werden können. Technisch ist das ein hoch spannendes Ergebnis, da hierdurch erklärt wird, wie der Ofen funktioniert. Insgesamt sind acht Parameter und einige Wechsel¬wirkungen zwischen Parametern analysiert worden, die in Abbildung 2 als Ergebnis des Modells alle gleichzeitig dargestellt werden.

Acht Dimensionen gleichzeitig!

Kommt man da nicht durcheinander? Und welcher Parameter ist eigentlich für die Temperaturvariation verantwortlich?

Dazu zeigt Abbildung 3 das Pareto Chart, in dem die Effekte ihrer Wichtigkeit nach geordnet sind. Das Ergebnis zeigt, dass die Parameter Glasdicke und Ofen-Verweilzeit haupt¬verantwortlich sind. Das ist aus tech¬nischer Sicht leicht ver¬ständlich. Als Weiteres ist erkennbar, dass die Ofennummer eine große Rolle spielt. Eine wichtige Erkenntnis, denn: Die Öfen sind also nicht gleich, obwohl drei gleiche Öfen gekauft wurden! Von den restlichen fünf Effekten sind zwar einige statistisch relevant (rechts von der blauen Linie), spielen jedoch technisch eine unter¬geordnete Rolle.

Das Ergebnis der Analyse:

- Die Temperatur im Ofen kann durch die Parameter Verweilzeit und Glasdicke vorhergesagt werden. Im Prozess kann damit aus dem Modell die Verweilzeit für jede Glasdicke berechnet werden, so dass die Zieltemperatur von 110°C erreicht wird.

- Die Streuungsanalyse zeigt, dass die Öfen geeignet sind, die Zielwerte zu erreichen, aber der Prozess zu höheren Temperaturen verschoben werden sollte.

- Eine Abhängigkeit von den anderen Parametern kann vernachlässigt werden.

- Für jeden Ofen muss ein separates Modell angewendet werden.

Dies ist ein ermutigendes Ergebnis, das sich aus vorhandenen Prozessdaten ergibt, wenn man die Daten im Kontext statistisch analysiert.

Aber fehlt da nicht etwas?

Hier kommen genau die Limitierungen der Daten aus Produktionsumgebungen zum Tragen: Der Produktionsverantwortliche weiß, dass die Ofentemperatur eine große Rolle spielt. Also hält er die Ofentemperatur immer konstant. Aus der Datenanalyse kann dann aber nicht angegeben werden, wie hoch der Einfluss dieses Parameters ist, da keine Variation in den Daten vorhanden ist.

Auch bei der Ofentemperatur muss im nächsten Schritt eine bewusste Variation herbeigeführt werden, um im Anschluss auch diesen Effekt bestimmen zu können. Dieser neue Parameter ermöglicht beispielsweise eine energetische Optimierung, wenn der Ofen bei niedrigerer Temperatur betrieben werden kann, ohne die Produktion zu verlangsamen. Um die Daten aus zielgerichteten Experimenten gewinnen zu können, liefert die Statistik mit der Statistischen Versuchsplanung ein Tool, um mit minimalem Aufwand den Einfluss einer großen Anzahl von Parametern ermitteln zu können.